15/04/2025

La Russie prend conscience des dangers de l'IA

Qui devrait être tenu responsable des dommages causés aux humains par la technologie ? Les acteurs du marché, les experts et les députés russes discutent actuelllement du projet de réglementation étatique de l'IA. Elle interdit les systèmes présentant un « niveau de risque inacceptable », introduit l’étiquetage du contenu et rend les développeurs responsables des dommages causés par les réseaux neuronaux.

Un groupe de travail spécialisé a élaboré un projet, il comprend des avocats, des représentants de sociétés de conseil et des acteurs du marché développant l'IA, ont-ils déclaré. L'initiative est présentée sous la forme d'un projet de loi « Sur la réglementation des systèmes d'intelligence artificielle (IA) en Russie ». Le document a été discuté lors des réunions des groupes de travail à la Douma d'État, à Delovaya Rossiya, ainsi que sur les plateformes de discussion du secteur.

La note explicative du projet précise qu'il a été élaboré pour mettre en œuvre la Stratégie nationale de développement de l'IA jusqu'en 2030 (approuvée en février 2024).

Andreï Svintsov, vice-président du Comité de la politique de l'information et membre du groupe de travail sur l'IA à la Douma d'État, a déclaré que désormais, sur instruction du président de la chambre basse du parlement, Viatcheslav Volodine, un groupe de travail a été créé « pour développer tout ce qui concerne la législation dans le domaine de l'IA ».

Selon lui, les initiatives législatives ne sont pas encore sérieusement examinées par les députés. « Le groupe de travail a été créé pour traiter avec soin et en détail toutes les demandes des différentes industries », a-t-il expliqué. Selon Svintsov, plusieurs initiatives devraient apparaître dans les prochains mois, « qui réglementeront spécifiquement certaines demandes de l'industrie, introduiront certaines zones pilotes ou régimes pilotes », mais il ne s'attend pas à un projet de loi qui réglementera toutes les activités d'IA cette année. Parmi les domaines qui seront réglementés en premier, le député a cité l'étiquetage. Mais la Douma d'Etat ne dispose pas encore d'une version finalisée du projet de loi, a-t-il souligné.

Les représentants de l'appareil gouvernemental et du ministère du Développement numérique affirment qu'ils n'ont pas reçu un tel projet de loi pour examen. Si cela arrive, ils l’examineront.

Dans l'Union Européenne, la situation est tout autre car la crise rend l'IA séduisante pour bien des raisons. Au cours de la dernière décennie, l'intelligence artificielle (IA) s'est imposée comme un moteur d'innovation technologique, de transformation économique et de mutation sociétale. Capable d'apprendre, de décider et d'agir, l'IA remet en question les cadres juridiques traditionnels, soulève de nouveaux risques pour les droits fondamentaux et interroge la responsabilité des décideurs publics comme privés. L'Union européenne (UE), consciente des dangers potentiels de cette technologie, a amorcé une réglementation ambitieuse, fondée sur une approche éthique et centrée sur les valeurs humanistes.

L'un des risques majeurs posés par l'IA concerne la vie privée. L'exploitation de données personnelles massives (big data), combinée à des systèmes de reconnaissance faciale, de détection d'émotions ou de suivi comportemental, menace la liberté individuelle. Le Contrôleur européen de la protection des données a alerté dès 2020 sur les dangers d'une « surveillance de masse automatisée ». L'IA est aussi porteuse de discrimination. Les algorithmes découlant de données biaisées reproduisent et amplifient les inégalités existantes, que ce soit dans le recrutement, le logement ou l'accès au crédit. Le cas de l'algorithme d'Amazon, qui défavorisait les candidatures féminines, est devenu emblématique.

La complexité des systèmes d'IA, notamment dans le deep learning, rend difficile l'identification d'une chaîne de responsabilité. Qui est responsable en cas de dommage causé par une IA : le développeur, l'utilisateur, le fournisseur de données, ou le fabricant du dispositif embarquant l'IA ? L'opacité de certains modèles, dits « boîte noire », pose des problèmes d'imputabilité juridique. La dépendance croissante aux systèmes intelligents dans les secteurs critiques (santé, finance, défense) expose les sociétés à des risques systémiques. Une défaillance ou une attaque ciblée sur une IA médicale ou une IA de gestion énergétique pourrait avoir des conséquences massives.

L'IA peut être détournée à des fins malveillantes : désinformation par deepfakes, cyberattaques automatisées, militarisation. Le rapport "Malicious Use of AI" (2018), cosigné par des universités et laboratoires internationaux, mettait en garde contre l'utilisation de l'IA à des fins de sabotage, d'espionnage ou de contrôle social. L'automatisation pilotée par l'IA pourrait supprimer jusqu'à 20 % des emplois dans certains secteurs, selon l'OCDE. Cela risque d'accentuer les inégalités entre pays, régions, classes sociales et générations. La préparation à cette transition est encore inégale au sein des pays membres.

L'utilisation croissante de l'IA dans l'éducation (assistants pédagogiques, tutoriels personnalisés, systèmes d'évaluation automatisée) n'est pas sans danger. Des contenus biaisés, voire manipulés, peuvent être introduits dans les parcours d'apprentissage. Le risque de propagande politique ou religieuse via des outils IA adaptés aux profils d'élèves est réel. L'UNESCO met en garde contre la capacité de l'IA à façonner les opinions des jeunes de manière invisible et à long terme.

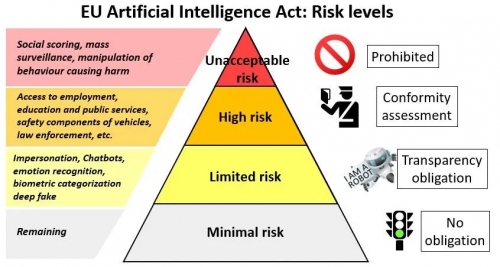

Face à ces dangers, la Commission européenne a présenté en avril 2021 une proposition de règlement : l'Artificial Intelligence Act (AI Act). Il s'agit du premier cadre juridique horizontal sur l'IA au monde. Le texte repose sur une classification des systèmes IA selon leur niveau de risque :

-

Risque inacceptable : systèmes interdits (notation sociale, manipulation cognitive, reconnaissance faciale en temps réel dans l'espace public sauf exceptions).

-

Risque élevé : systèmes soumis à obligations strictes (santé, éducation, justice, emploi).

-

Risque limité : obligations de transparence (chatbots, deepfakes).

-

Risque minimal : systèmes libres, non soumis à contraintes.

L'AI Act impose des obligations aux développeurs et fournisseurs : gestion des risques, transparence, documentation technique, auditabilité, surveillance humaine.

Des autorités nationales seront désignées pour contrôler l'application du règlement. Un Comité européen de l'intelligence artificielle coordonnera les politiques. Des obligations d'étiquetage et d'explicabilité sont prévues. Les systèmes d'IA à haut risque devront faire l'objet d'évaluations de conformité. Des sanctions allant jusqu'à 6 % du chiffre d'affaires annuel mondial sont prévues en cas de violation. L'AI Act, bien qu'innovant, suscite des débats. Les défenseurs des droits humains estiment que certaines exceptions (notamment pour la surveillance) restent trop larges. Les entreprises, de leur côté, redoutent une charge administrative excessive. L'enjeu est de concilier protection des citoyens et compétitivité technologique. Des ajustements sont prévus dans les textes d'application.

L'Union européenne tente d'imposer un modèle fondé sur l'éthique, la responsabilité et la transparence, face à des approches plus permissives (comme aux États-Unis) ou plus autoritaires (comme en Chine). La réglementation de l'IA constitue un enjeu décisif pour la souveraineté numérique de l'Europe, mais aussi pour la défense de ses valeurs fondamentales. Comme le rappelait la présidente de la Commission, Ursula von der Leyen, « la confiance est le prérequis de l'IA ». Le régime européen en construction pourrait bien servir de référence mondiale à l'ère des machines pensantes. Mais qui va encore fait confiance à la Commission après la fable climatique, la Terreur sanitaire, la censure de médias russes et l'impossibilité d'activité de déseaiux sociaux américains et le soutien à Kiev incompatible avec les valeurs qu'elle prétend défendre ?

Qu'envisage de son côté le projet de loi russe ?

- Introduire le concept d'intelligence artificielle (un ensemble de solutions technologiques et logicielles qui imitent les fonctions cognitives humaines, notamment l'auto-apprentissage, la recherche de solutions sans algorithme prédéterminé et la garantie de l'obtention de résultats comparables aux résultats de l'activité intellectuelle humaine).

- Le concept des technologies d’IA (celles-ci incluent les technologies de vision par ordinateur, le traitement du langage naturel, la reconnaissance et la synthèse de la parole, l’analyse intelligente des données, l’apprentissage automatique, etc.).

- Le concept de systèmes d’IA (systèmes d’information qui imitent les fonctions cognitives humaines en utilisant les technologies énumérées ci-dessus), le développeur, l’opérateur et l’utilisateur de ces systèmes, etc.

- Introduire des exigences pour l’étiquetage des systèmes d’IA, c’est-à-dire une désignation informative obligatoire qui indiquera l’utilisation de l’IA lors de l’interaction avec l’utilisateur. Le marquage doit être « clair, sans ambiguïté et facilement identifiable ». Elle doit être fournie par l’opérateur du système d’IA avant chaque interaction avec l’utilisateur. Cette exigence ne s’appliquera pas aux systèmes d’IA utilisés dans les processus technologiques fermés, pour l’automatisation interne des organisations et un certain nombre d’autres.

- Introduire une classification des systèmes d’IA selon le niveau de risque potentiel : systèmes présentant un niveau de risque inacceptable, élevé, limité et minimal. Il est proposé d’interdire en Russie le développement et l’exploitation de systèmes d’IA qui entrent dans la catégorie d’un niveau de risque inacceptable, c’est-à-dire ceux qui constituent une menace pour la sécurité de l’individu, de la société et de l’État, et qui violent également les droits et libertés fondamentaux de l’homme et du citoyen ; pour les systèmes à haut risque (ceux utilisés dans les soins de santé, les transports, la finance, l’application de la loi et d’autres domaines où cela peut créer des risques importants pour la vie, la santé, les droits et libertés fondamentaux des citoyens), introduire un enregistrement et une certification obligatoires par l’État ; pour ceux qui présentent un niveau de risque limité - systèmes de contrôle qualité internes, certification volontaire.

- Introduire la responsabilité des personnes impliquées dans le développement et l’exploitation de systèmes d’intelligence artificielle en cas de préjudice causé à la vie, à la santé ou aux biens. Mais le document stipule que le développeur ne sera pas tenu responsable s'il a pris toutes les mesures nécessaires pour prévenir un préjudice, si le préjudice est survenu en raison d'une violation des règles d'utilisation du système, et dans plusieurs autres exceptions, l'opérateur de systèmes d'IA sera dégagé de sa responsabilité s'il prouve que le préjudice est survenu en raison de la faute du développeur à la suite de la violation par l'utilisateur des règles d'utilisation du système, etc. Il est proposé d'introduire une assurance responsabilité civile obligatoire pour les opérateurs de systèmes d'IA à haut risque.

- Pour déterminer à qui appartiennent les droits sur le résultat d’une activité intellectuelle créée à l’aide de l’IA, il est proposé de se concentrer sur la question de savoir s’il y a eu une contribution créative significative d’une personne (si la personne a déterminé les paramètres et les critères de création du résultat, si elle a fait une sélection et une révision créatives, si elle a pris des décisions créatives dans le processus de création). Si une telle contribution a été apportée, le droit exclusif sur le résultat devrait appartenir à cette personne ; sinon, à l'opérateur du système d'IA (valable 50 ans).

Si le document est adopté dans sa forme actuelle, les opérateurs et les développeurs de systèmes d’IA devront se conformer à ses exigences dans un délai d’un an après son entrée en vigueur ; Les systèmes d’IA à haut risque créés avant l’adoption du projet devront subir une certification obligatoire dans un délai de deux ans.

Le gouvernement aurait précédemment déclaré qu'il était prématuré de réglementer cette technologie. Par exemple, en février de cette année, le vice-Premier ministre Dmitri Grigorenko a déclaré qu’une réglementation législative de l’IA n’était pas prévue pour les deux prochaines années.

« Les entreprises russes mettent en œuvre des mesures d'autorégulation, utilisent l'étiquetage du contenu généré par l'IA et agissent sur la base des normes de l'industrie pour le développement responsable des technologies d'intelligence artificielle », explique une source de RBC. « Une réglementation excessive et hâtive ralentira le développement d’une industrie stratégiquement importante pour l’économie du pays, limitera les opportunités et les avantages des technologies pour les utilisateurs et les entreprises, et entraînera un retard technologique des acteurs nationaux. » Il a souligné que l’impact négatif de la réglementation peut être observé dans l’exemple des entreprises européennes : la loi sur l’IA dans l’UE a conduit les leaders du marché à réduire leur présence dans la région, et leurs propres solutions compétitives n’émergent pas.

Roman Khazeev, directeur des technologies numériques de Rostelecom, affirme qu'à l'heure actuelle, nulle part dans le monde il n'existe une base législative et des pratiques suffisantes pour déterminer la responsabilité des développeurs de réseaux neuronaux, les limites de la créativité et le fait d'utiliser des deepfakes. « On pourrait croire que les initiatives législatives dans ce domaine sont en voie de rattrapage. Or, ce n'est pas le cas : l'introduction de normes réglementaires n'est souhaitable qu'après une certaine stabilisation des processus et la formation de problèmes de régulation au niveau législatif », explique Khazeev, soulignant que l'utilisation de deepfakes est de plus en plus fréquente et qu'il est difficile de distinguer les informations authentiques des informations fictives.

Les représentants de Yandex, MTS et VK ont refusé de commenter ce projet et ils sont pourtant des acteurs majeurs de l'IA en Russie.

Créé en 1997, Yandex est souvent surnommé le "Google russe". Leader du marché des moteurs de recherche en Russie avec plus de 60 % de parts de marché, Yandex est bien plus qu’un simple moteur de recherche. L’entreprise est devenue un conglomérat technologique opérant dans des domaines aussi variés que la cartographie, la publicité numérique, la livraison, les véhicules autonomes et l’assistance vocale.

L’intelligence artificielle est au cœur de l’écosystème Yandex :

-

Le moteur de recherche de Yandex utilise des algorithmes sophistiqués de compréhension sémantique, notamment le réseau neuronal YaLM (Yandex Language Model), développé pour le traitement du russe et des langues slaves.

-

Voix et assistant IA : Alice (Алиса), l’assistant vocal de Yandex, est l’un des plus avancés en Russie. Il combine NLP, reconnaissance vocale et génération de texte. L’assistant est intégré à de nombreux produits Yandex (navigateur, enceintes connectées, systèmes domotiques).

-

Véhicules autonomes : Yandex investit massivement dans la conduite autonome. Depuis 2017, le groupe développe ses propres voitures sans conducteur, testées à Moscou, Kazan, Tel-Aviv ou encore Ann Arbor (États-Unis). Ces véhicules utilisent une combinaison d’IA pour la vision par ordinateur, la prédiction comportementale et la navigation.

-

Recommandation et publicité : Yandex utilise des moteurs de recommandation basés sur l’IA dans Yandex.Market, Yandex.Music et Yandex.Taxi. Cela permet une personnalisation fine des contenus et des publicités.

En 2023, Yandex a officiellement scindé une partie de ses opérations à l’étranger pour se recentrer sur les activités en Russie, avec une intensification des efforts dans les infrastructures critiques liées à l’IA.

MTS (Mobile TeleSystems), fondé en 1993, est l’un des principaux opérateurs de téléphonie mobile et de services numériques en Russie. Longtemps associé aux télécommunications, le groupe s’est transformé ces dernières années en un acteur technologique complet, avec des ambitions croissantes dans l’intelligence artificielle.

Les initiatives IA de MTS sont variées :

-

Traitement des données clients : MTS gère des volumes massifs de données issues des réseaux mobiles. L’entreprise utilise l’IA pour analyser le comportement des usagers, optimiser la qualité du service, détecter les fraudes et personnaliser les offres.

-

Reconnaissance faciale et vidéosurveillance intelligente : MTS propose des solutions IA pour les villes intelligentes, la sécurité publique et les entreprises. Ces systèmes utilisent des algorithmes d'analyse vidéo pour la détection d'intrusions, l'identification de comportements suspects ou la reconnaissance d'individus sur la base de bases de données.

-

MTS AI (branche dédiée) : En 2021, MTS a lancé MTS AI, une filiale consacrée à l’intelligence artificielle, avec un centre de R&D basé à Moscou. Cette entité développe notamment :

-

des outils de NLP pour le russe,

-

des plateformes d’automatisation des processus métiers (RPA),

-

des modèles de diagnostic médical assisté par IA.

-

Souveraineté technologique : MTS a déclaré investir massivement dans des alternatives russes aux services cloud et aux logiciels occidentaux, souvent en lien avec des applications IA. L’objectif affiché est de garantir la résilience du pays face aux sanctions et de renforcer la souveraineté numérique.

MTS ambitionne de devenir l’un des principaux fournisseurs russes d’IA B2B et B2G (Business to Government), en alignement avec les orientations stratégiques du gouvernement.

VK (anciennement Mail.Ru Group, renommé en 2021), est le plus grand groupe de médias sociaux et de services internet de Russie. Il est notamment propriétaire du réseau social VKontakte, souvent décrit comme le "Facebook russe", ainsi que de Odnoklassniki, Mail.ru, Boom, et d’une multitude de services de jeux, d’éducation et de streaming.

VK mise sur l’IA pour renforcer l'engagement utilisateur :

-

Algorithmes de recommandation : L’IA est utilisée pour proposer du contenu personnalisé dans les flux de VKontakte, YouTube-like VK Video, ou la plateforme musicale Boom. Les systèmes apprennent les préférences des utilisateurs en temps réel.

-

Modération automatisée : Pour faire face à la diffusion massive de contenus, VK utilise des modèles d’IA capables de détecter des propos haineux, des contenus inappropriés ou de la désinformation.

-

Reconnaissance d’images et NLP : VK développe ses propres solutions de reconnaissance d’image (ex : détection de visages, objets, contexte visuel) et de traitement du langage pour améliorer la recherche, la traduction et la compréhension des interactions utilisateurs.

-

VK Cloud et IA-as-a-Service : En réponse au besoin croissant d’infrastructures souveraines, VK a lancé des services cloud intégrant des solutions d’IA à destination des entreprises et développeurs. VK Cloud offre des API pour la vision par ordinateur, la reconnaissance vocale et la traduction automatique.

Le groupe collabore étroitement avec des institutions d'État et joue un rôle central dans les projets éducatifs, notamment dans le domaine de l’e-learning alimenté par IA. Certaines critiques pointent cependant le risque de contrôle idéologique des contenus, VK étant partiellement contrôlé par des entités proches du pouvoir.

Yandex, MTS et VK représentent la colonne vertébrale du développement de l’intelligence artificielle en Russie. Tous trois investissent massivement dans la recherche, les infrastructures cloud, les assistants intelligents, la cybersécurité et les solutions d’IA appliquées aux besoins des citoyens et des administrations.

Mais leur rôle dépasse la simple innovation technologique : en lien étroit avec les priorités stratégiques de l’État russe (Stratégie nationale de développement de l’IA 2030), ces groupes incarnent une vision souveraine, centralisée et pilotée par la puissance publique. L’IA y est conçue non seulement comme un moteur de croissance économique, mais aussi comme un instrument de sécurité, de gouvernance et de contrôle social.

À ce titre, la comparaison avec le modèle européen, fondé sur la protection des droits fondamentaux et la transparence algorithmique, met en lumière deux visions contrastées du futur numérique mondial.

13:48 Publié dans Actualité | Lien permanent | Commentaires (0) |  |

| ![]() Facebook | | |

Facebook | | |

Les commentaires sont fermés.